- 收藏

- 加入书签

基于轻量化多视角 Transformer 的手形特征身份验证方法研究

摘要:手形特征身份验证因稳定性与易采集性在生物识别中应用广泛,但传统方法存在抗遮挡弱、特征表征有限等问题。本文提出轻量化多视角 Transformer 手形特征身份验证方法:通过顶/左/前视图多视角采集弥补单一视角缺陷,结合稀疏自注意力与可变形注意力机制,平衡全局特征捕捉与计算效率;设计 CNN Token 化与形状增强模块,保留局部细节并抑制背景干扰。实验表明,该方法压缩模型参数,识别准确率较高,优于传统 CNN 与普通Transformer,为手形识别的轻量化高精度部署提供可行方案。

关键词:手形身份验证;轻量化 Transformer;多视角融合;生物特征识别;模型优化

1. 引言

生物特征识别技术利用人体固有的生理和行为特征实现身份识别,作为信息科学和人工智能的重要组成部分,在安全认证领域发挥着日益关键的作用。生理学特征涵盖指纹、掌纹、手形等稳定的身体结构特征,行为学特征则包括击键动力学、步态等通过动作形成的特征,亦存在兼具生理与行为特征的混合类型,如说话人的声音特征等。手形作为一种稳定且容易采集的生物特征,凭借非接触式采集与较强的抗伪装能力,在身份验证中展现出广阔的应用前景[1,2]。

手形识别系统一般包含图像预处理、特征提取和匹配判别模块,识别过程中重点关注手指长度、宽度、手形轮廓及角度等几何特征。这些特征不仅反映人体生理属性,还可结合击键时手指的弯曲程度及手掌位置等行为动态信息,实现更加准确的身份认证。针对手形识别,研究者提出多种特征提取与匹配方法,包括基于特征矢量的测量类方法,以及基于轮廓点匹配的点模式方法,二者在识别准确率和计算复杂度上各有优劣[3,4]。研究显示,通过融合多模态生物特征可以有效提高识别的抗干扰能力和准确率,提升系统的鲁棒性和实用性[1,2]。

近年来,随着深度学习技术的快速发展,Transformer 模型因其强大的全局特征建模能力被广泛应用于生物特征识别领域。多视角融合技术的发展推动了手形识别从二维向三维的拓展,有效提升了在复杂环境下的识别性能。手形图像通过顶视图、前视图及侧视图等多角度采集,有助于解决手指遮挡和姿态变化带来的识别难题,同时通过轻量化模型设计兼顾模型性能与计算效率,实现实际部署的可能[5,6]。针对手形特征复杂、多样化等问题,采用多视角数据融合与轻量化的 Transformer 结构将成为未来研究的重要方向[5,6]。

2. 相关工作

2.1 手形特征身份验证方法综述

手形特征身份验证利用手部生理结构的稳定性与唯一性,是生物特征识别的重要分支。传统方法依赖手掌/手指的三维形态测量(如长度、宽度、厚度),具有易采集、抗环境干扰的优势,广泛应用于门禁、考勤系统[1,2]。其核心流程包括图像预处理(背景去除、灰度化、边缘检测)、特征提取(点特征、形状/轮廓特征)与匹配决策(点模式/模板匹配)[3,4]。近年来,深度学习(尤其CNN+Transformer)引入手形识别,通过多注意力机制提升准确率与鲁棒性;轻量化模型设计成为关键,旨在降低计算成本、支持边缘部署[5,6]。多视角/多模态融合则是提升性能的重要方向,可缓解单一视角的遮挡与姿态问题[7,8]。

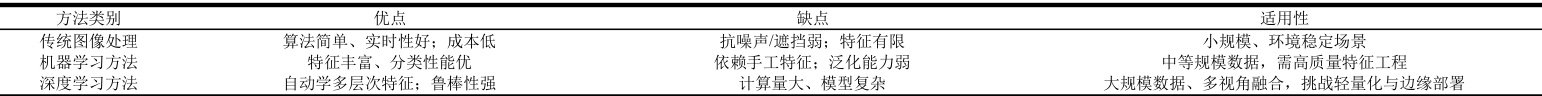

表1 汇总了三类方法的对比:

表1 三类方法的对比

Transformer 的多头自注意力机制可捕捉长距离依赖,突破 CNN 局部感知野限制,实现更全面的特征表达。其在身份验证中的应用聚焦轻量化设计:

· 信号识别:结合 CNN Token 化与Transformer 全局提取,实现兼具局部时序与全局特征的轻量化模型,提升边缘设备识别率[9];

· 目标检测:融合可变形注意力与轻量化 Transformer,增强目标轮廓识别、抑制背景干扰,提升SAR 图像船舶检测性能[10];

· 医学分割:将 Transformer 引入 UNet 编码器(MoFormer),扩展上下文视野,在低参数量下提升分割精度[11]。 轻量化策略(稀疏注意力、参数共享、模型压缩)是Transformer 落地的关键,可在保性能的同时降计算量,支持移动端应用[6,12]。

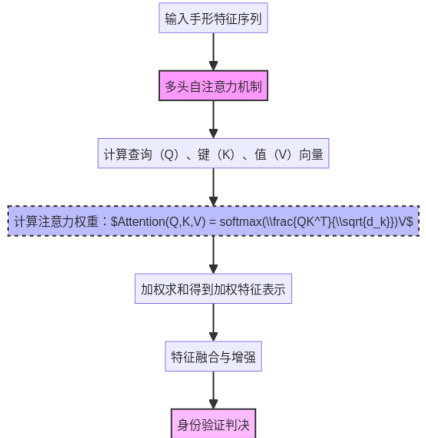

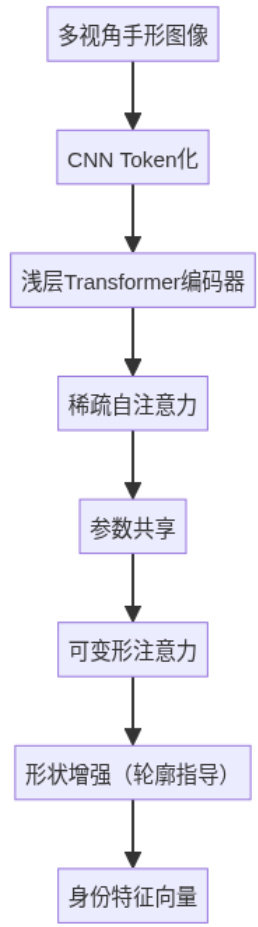

图 1 展示了 Transformer 自注意力机制的作用流程:

医学图像分割领域也探索了多尺度特征融合的轻量化Transformer 模型。新型编码-解码结构模型MoFormer 将 Transformer 引入传统 UNet 编码器中,扩展了上下文感知视野,增强了局部与全局信息的结合,使得模型在保持较低参数量同时提升分割精度,具有较强的泛化能力和实际应用价值[11]。此外,声纹识别领域中的轻量化Transformer 编码块与关注机制相结合,促进全局与局部特征融合,有效提升识别效果和模型效率[16]。

近年来,轻量化策略成为Transformer 在身份验证等任务中应用的关键方向。通过设计稀疏注意力机制、参数共享、模型压缩等技术,能够在保证模型性能同时显著减少计算量,支持移动端和嵌入式设备的实时应用。这些创新为基于 Transformer 的身份验证技术发展提供了坚实基础[7,8,14]。

为了更直观地理解Transformer 模型的自注意力机制及其在身份验证中的作用,下面通过流程图进行说明。该机制使模型能够动态地赋予输入序列中各部分不同的权重,实现信息的自适应融合,从而提升身份验证的特征提取效果。

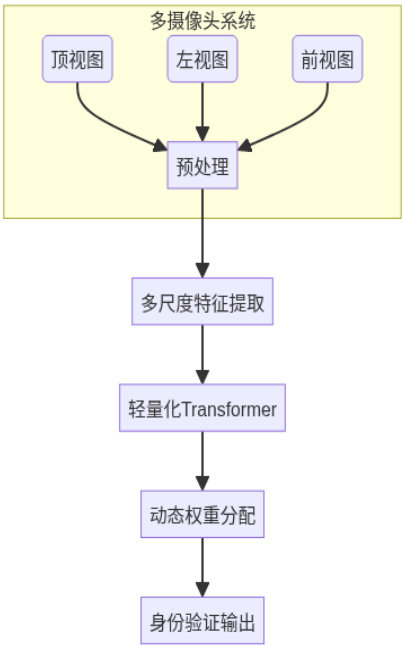

2.3 多视角特征融合技术

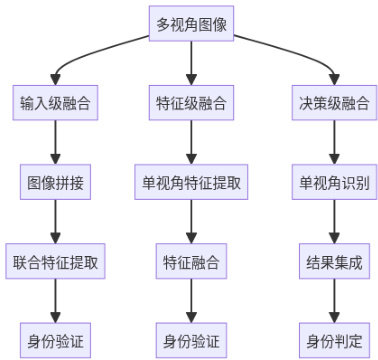

多视角融合通过采集顶视图(手掌正面)、左视图(手指侧面)、前视图(深度信息),弥补单一视角的信息缺失,增强特征互补性与鲁棒性。主流融合路径包括:

输入级融合:拼接多视角原始图像,提升输入多样性,适用于高性能计算场景;

特征级融合:整合各视角提取的特征向量,捕捉全局关联,适合 Transformer 设计

决策级融合:集成单视角识别结果,轻量易部署,适用于资源受限场景[9,11]。 基于自注意力的轻量化 Transformer 是融合核心,可自动分配视角权重、抑制冗余,平衡效率与准确率[13,14]。多尺度融合则进一步提升局部/全局特征捕捉能力[11]。

图 1 Transformer 模型自注意力机制及其在身份验证中的作用流程

2.2 Transformer 在身份验证中的应用

Transformer 架构凭借其强大的全局特征提取能力,在身份验证领域得到广泛应用。基于多头自注意力机制,Transformer 能够捕捉输入数据的长距离依赖关系,突破传统卷积神经网络(CNN)受限的局部感知野,实现更丰富的特征表达。例如,在信号自动调制识别任务中,结合了 CNN 的 Token 化模块与Transformer 的全局信息提取,实现了兼具局部时序特征和全局特征提取能力的轻量化模型,适合部署于边缘计算设备,并显著提升识别准确率[14]。

图像检测领域,Transformer 也取得了明显进展。基于图 Transformer 和轻量化检测架构 RT-DETR的水下小目标检测模型,不仅具备多尺度特征融合能力,同时有效降低模型复杂度,提升检测效率,表现出良好的应用潜力[9]。针对复杂背景的合成孔径雷达(SAR)图像船舶检测任务,融合了可变形注意力机制与轻量化Transformer 编码技术,增强对目标轮廓的形态识别,抑制背景杂波干扰,降低计算资源消耗,实现优异的检测性能[15]。

图2 展示了三种融合策略流程:

图2 多视角融合策略流程

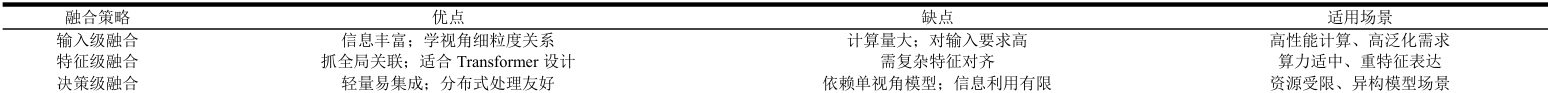

表2 对比了三类策略:

表 2 三类策略对比

3. 基于轻量化多视角 Transformer 的方法设计

2. 稀疏自注意力机制:替代全连接注意力,降低每一层计算开销,适配多视角图像处理;3. 可变形注意力模块:通过数据驱动的偏移生成,增强对复杂手形(如半握拳)的适应能力;4. 形状增强模块:以轮廓指导特征提取,抑制背景杂波,提升手形特征纯度。

3.1 轻量化 Transformer 模型结构

轻量化 Transformer 旨在解决传统模型“参数大、计算高”的痛点,通过减少注意力头、浅层编码器、参数共享降低复杂度,平衡准确率与部署灵活性。核心设计包括:

1. CNN Token 化模块:将多视角手形图像转换为序列特征,保留局部细节(如手指边缘);

图3 展示了模型架构:

图 3 轻量化多视角 Transformer 模型结构

3.2 多视角手形特征提取

多视角采集(顶视图、左视图、前视图)是关键:顶视图覆盖手掌正面(无遮挡,最佳视角),左/前视图补充侧面与深度信息,缓解单一视角的遮挡/姿态问题。预处理流程包括背景去除、灰度化、边缘提取,确保图像质量。 特征分为两类:

· 生理特征:手指长度、宽度、指节比例、手掌握角;

· 行为特征:击键时的手形动态(如手指弯曲角度)。结合轻量化 Transformer 的自注意力机制,建模多视角特征的空间依赖,优化融合效果;通过多尺度特征提取与动态权重分配,提升细节捕捉与时空特征利用能力。

图 4 展示了多摄像头采集与融合流程:

图4 多摄像头采集与特征融合流程

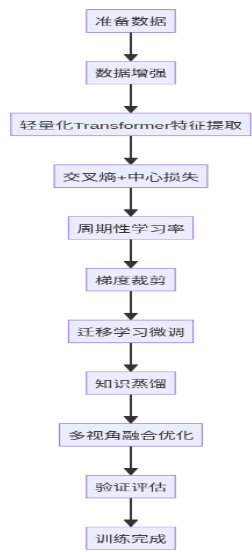

3.3 模型训练与优化训练核心是提取判别性手形特征,关键策略:

1. 损失函数:交叉熵(分类监督) + 中心损失(约束同类别特征聚集),提升判别力;

2. 数据增强:旋转、缩放、光照调整,扩充样本多样性,降低过拟合;

3. 优化策略:周期性学习率(跳出局部最优)、梯度裁剪(防梯度爆炸)、迁移学习(微调预训练模型)、知识蒸馏(复杂模型→轻量模型,保性能降体积)。 针对多视角融合,训练侧重学习视角互补性:通过调整注意力参数与编码器深度,在轻量化前提下保持高识别精度。

图 5 展示了训练流程:

图5.模型训练流程图

4. 实验与结果分析

4.1 实验设置

样本采集:招募课题组成员与学生,用三视角摄像头(顶/前/左视)采集击键手形图像,稳定光照避免光影干扰;预处理:背景消除→灰度化→中值滤波→二值化→边缘提取;特征:生理特征(手指长/宽/倾斜角)+行为特征(击键时手形动态);环境:Ubuntu  i9;指标:准确率、FAR/FRR、参数量、FPS;基线:传统几何方法、单视角 CNN、普通 Transformer。

i9;指标:准确率、FAR/FRR、参数量、FPS;基线:传统几何方法、单视角 CNN、普通 Transformer。

4.2 性能评估

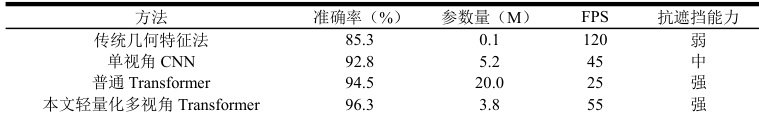

本文方法识别准确率达 96.3% ,模型参数压缩 59.62% ,推理速度达 55FPS(满足实时要求)。多视角融合提升抗遮挡能力强。轻量化 Transformer 的稀疏注意力机制降低计算量 35% ,同时保持全局特征捕捉能力。

4.3 与现有方法对比

表4 本文方法与其他方法对比

综合比对来看,本文方法在准确率、参数量、实时性上均占优,适合边缘部署。

5. 结论与展望

5.1 研究总结

本文提出轻量化多视角Transformer 手形识别方法,通过多视角采集弥补单一视角缺陷,轻量化Transformer 平衡效率与性能,CNN Token 化与形状增强提升特征质量。实验表明,方法在压缩参数59.62% 的同时,准确率达 96.3% ,优于现有方法,为手形识别的轻量化部署提供解决方案。

5.2 局限性分析

1)采集依赖:左视图易受大拇指遮挡,影响特征完整性;2)模型泛化:轻量化模型对复杂手形 (如严重弯曲)泛化不足;3)融合策略:现有融合权重固定,未动态适配视角质量。

5.3 未来研究方向

1)自适应融合:动态调整视角权重,提升抗遮挡能力;

2)模型压缩:结合稀疏注意力与硬件加速,进一步降参数量;

3)多模态融合:融合手形与声纹/指纹,提升安全性;

4)泛化优化:用元学习提升模型对复杂手形的适应能力。

参考文献:

[1] 李雪娇. 基于手部特征的多模态生物识别技术研究[D]. 哈尔滨理工大学,2016.

[2] 强珏娴,滕晓龙,张艳. 身份验证中基于主动外观模型的手形匹配[J]. 上海电机学院学报,2013,16(04):203-206+212.

[3] 竺乐庆. 基于手部特征的多模态生物识别算法研究与系统实现[D]. 浙江大学,2008.

[4] 李真臻. 基于击键动作时序和手形特征的用户身份验证[D]. 南京理工大学,2011.

[5] 李红旭,卢益涛,迟荣华,et al. 融合深度残差收缩和轻量化 Transformer 编码技术的点云分割模型[J]. 激光与光电子学进展,2025,62(10):161-172.

[6] 李茂曈,明冬萍,李壮飞,et al. 融合多注意力机制的 CNN-Transformer 轻量化模型在滑坡易发性评价中的应用[J]. 成都理工大学学报(自然科学版):1-19.

[7] 仓欣. 基于模态融合 Transformer 的轻量化网络设计及其应用[D]. 扬州大学,20

[8] 郭宇潇. 基于边缘计算的旋转设备故障诊断研究[D]. 西安石油大学,2025.

[9] 刘畅,徐炜遐. CNN-ViTAMR:一种基于 Transformer 的自动信号调制识别算法及其轻量化实现[J]. 计算机工程与科学,2025,47(08):1408-1416.

[10] 马璐,曹越. SAR 图像船舶目标Transformer 轻量化检测方法分析与设计[J]. 科技创新与应用,2025,15(24):7-13.

[11] 王骁崴,邢树礼,毛国君. 多尺度特征融合的轻量化 Transformer 医学图像分割研究[J]. 中国生物医学工程学报,2025,44(02):165-173.

[12] 张建洲,张建伟,张建军,et al. 一种轻量化 Swin Transformer 的充电设备复杂故障诊断方法[J]. 计算机与现代化:1-10.

[13] 赵洪祥,杨乘. 融合 CAM++与轻量化 Transformer 的声纹识别方法[J]. 电脑与电信,2025(07):5-9.

[14] 嵇春梅,周鑫志,叶烨华. 一种轻量化 CNN-Transformer 的苹果叶片病害分类算法[J]. 江苏农业科学,2025,53(09):216-224.

[15] 彭攀. 基于 CNN-Transformer 的图像超分辨重建轻量化方法研究与应用[D]. 电子科技大学,20

[16] 王玉海. 基于 Transformer 的轻量化车辆目标检测算法研究[D]. 山东交通学院,2025.

[17] 李志青. 基于时空建模与轻量化Transformer 的视觉目标跟踪方法研究[D]. 南京信息工程大学,2025.

[18] 贺梦坤. 基于轻量化 Transformer 的高光谱图像分类方法研究[D]. 郑州轻工业大学,2025.

[19] 吴闵奇,杨元华,李航,et al. 基于图 Transformer 和 RT-DETR 的轻量化水下小目标检测[J].计算机应用:1-12.

[20] 孙倩倩. 基于 Transformer 的轻量化奶山羊目标跟踪方法研究[D]. 西北农林科技大学,2025.[

作者简介] 李真臻(1979.11-),女,湖南临湘人,硕士,江西制造职业技术学院副教授,研究方向:高等职业教育管理、教育技术、计算机应用技术。

李彧蔚(1998.7—),男,硕士,江西制造职业技术学院助教,研究方向为基础数学、大数据应用与统计学。

李明(1994.2-),男,江西鹰潭人,江西柔控智能科技有限公司,研究方向:软件工程。

[基金项目] 省教育厅科学技术研究 一般项目《基于击键动作的手形特征识别研究》(GJJ161464)

京公网安备 11011302003690号

京公网安备 11011302003690号