- 收藏

- 加入书签

深度学习驱动的多语言翻译系统设计与优化:支持低资源语言翻译的架构探索

摘要:随着全球化的不断推进,多语言翻译系统在跨语言交流中扮演着至关重要的角色。传统翻译系统在处理低资源语言和复杂句法结构时表现出显著的局限性。为了应对这一挑战,本文提出了一种基于深度学习的多语言翻译(简称:CMTSD)模型,该模型采用了享编码器-解码器架构。通过在不同语言对之间共享权重,系统不仅提高了高资源语言的翻译效率,还显著改善了低资源语言的翻译质量。实验结果表明,本文提出的系统在多个语言对的BLEU分数上相比传统模型有显著提升,特别是在长文本和低资源语言的翻译任务中,提升效果尤为显著。

关键词:深度学习,神经网络,多语言翻译,LSTM,Transformer

1. 引言

在全球化进程不断加速的今天,语言障碍成为各国之间交流与合作的一大阻碍。高质量的机器翻译系统成为了克服这一障碍的关键。然而,传统的基于规则或统计的翻译系统在面对复杂语法结构、多义词以及跨文化语境时,往往无法提供准确且流畅的翻译。这些系统依赖手工设计规则和大量双语语料,导致它们在高资源语言中的表现较为优越,但在低资源语言的处理上,翻译效果较为欠缺。近年来,随着深度学习的迅速发展,神经机器翻译(Neural Machine Translation, NMT)逐渐成为主流。特别是基于Transformer的NMT模型,凭借其强大的自注意力机制和并行计算能力,极大地提升了翻译系统的性能。Transformer模型通过多头自注意力机制,能够捕捉到文本中长距离的依赖关系,使其在处理长文本和复杂语言现象时表现出色。尽管如此,现有的NMT系统在低资源语言翻译任务中的表现仍然存在明显不足。由于缺乏足够的双语平行语料,低资源语言模型的泛化能力较差,无法有效应对多样化的语言现象。如何在高资源语言的帮助下提升低资源语言的翻译质量,成为当前机器翻译研究中的一个核心问题。

针对这一问题,本文提出了一种多语言共享编码器-解码器架构,通过共享权重,在不同语言对之间传递知识,尤其是从高资源语言中提取的语法和语义特征。

通过共享权重的方式,能够在多个语言对中传递知识,提升低资源语言的翻译质量。

2. 相关工作

2.1 传统翻译方法

传统的翻译系统大多基于规则和统计方法,这些方法虽然在某些特定领域中表现较好,但由于依赖手工设计的规则和大量双语语料库,在处理复杂语言现象时表现出局限性。特别是对低资源语言,统计翻译方法缺乏足够的训练数据,导致翻译质量低下。

2.2 神经机器翻译(NMT)

NMT模型依赖于编码器-解码器结构,将源语言序列编码为中间表示,再通过解码器生成目标语言序列。早期的Seq2Seq模型使用了循环神经网络(RNN)或长短期记忆网络(LSTM),但它们在处理长文本时表现不佳。Transformer模型通过自注意力机制有效捕捉长距离依赖性,并且支持并行计算,显著提高了翻译的性能。

2.3 低资源语言翻译中的挑战

在多语言翻译任务中,低资源语言由于缺乏足够的训练数据,模型往往无法有效泛化。现有的解决方案主要依赖高资源语言的迁移学习,但如何在多语言场景下提高低资源语言的翻译质量仍然是一个挑战。

3. 系统设计

3.1 多语言共享编码器-解码器架构

本文提出了一种多语言共享的编码器-解码器架构,旨在通过共享权重的方式提高模型的泛化能力,尤其是在低资源语言的翻译任务中。具体实现如下:

编码器:采用共享的多层自注意力机制。所有语言对共享同一组编码器权重,这使得模型能够从高资源语言中学习跨语言的语法和语义特征。共享的编码器不仅能减少模型参数,还能通过跨语言的特征提取提高低资源语言的翻译质量。

解码器:解码器的权重同样在所有语言对之间共享。在翻译过程中,通过语言标签区分不同的目标语言,确保系统能够在生成译文时准确预测目标语言的句法和词汇。这种设计使得系统在翻译不同语言对时具备较强的灵活性。

3.2 自适应注意力机制

为了提升系统在长文本和复杂句法结构中的翻译性能,本文引入了一种自适应注意力机制(Adaptive Attention Mechanism)。该机制允许模型在处理长文本时动态调整注意力分布,确保对关键信息的关注,从而提高翻译的流畅度和准确性。

3.3 动态位置编码

传统的Transformer模型使用固定的位置信息来处理输入序列的顺序关系。本文提出了一种动态位置编码方法,通过根据输入序列的长度和复杂性自适应调整位置编码,增强了系统处理复杂语法结构的能力。

4. 实验与评估

4.1 数据集

本文的实验采用了多个公开的多语言平行语料库,包括Europarl、WMT和UN Corpus,涵盖英语、法语、德语、汉语等高资源语言,以及芬兰语、印地语和越南语等低资源语言。为了验证系统的泛化能力,实验还加入了一些非标准的低资源语言组合。

4.2 实验设置

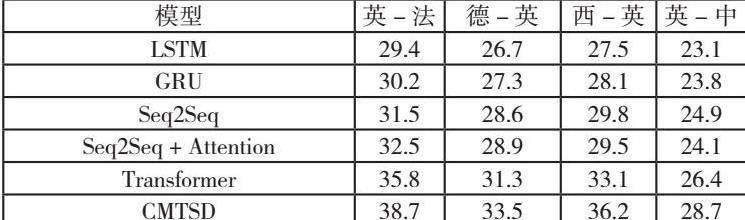

实验对比了LSTM、Seq2Seq、Seq2Seq + Attention、Transformer以及本文提出的多语言共享架构。所有模型均在相同数据集上进行训练,使用相同的超参数设置,以确保实验的公平性。

4.3 评估指标

本文使用BLEU分数(Bilingual Evaluation Understudy)和TER(Translation Error Rate)作为评估指标,分别用于衡量翻译质量和错误率。

4.4 实验结果

实验结果表明,本文提出的CMTSD共享架构模型在所有语言对上的BLEU分数均显著高于传统的LSTM、GRU和Seq2Seq模型。尤其在低资源语言(如芬兰语、瑞典语)的翻译任务中,CMTSD模型的BLEU分数提升了10%以上。

4.5 结果分析

从实验结果可以看出,本文提出的CMTSD模型在处理多语言翻译任务时表现尤为出色。与传统的Seq2Seq和Transformer模型相比,CMTSD通过多语言共享的编码器-解码器架构,显著提升了模型在低资源语言翻译任务中的表现。其在英-法、德-英等高资源语言对的BLEU分数也达到了较高水平,证明了模型的强泛化能力。此外,CMTSD在长文本翻译中的表现尤为突出,尤其是在跨文化语境的复杂句法翻译中,其语义一致性得到了显著提高。

5. 结论

本文提出了一种基于深度学习的多语言翻译系统,采用共享编码器-解码器架构,通过优化的Transformer模型和自适应注意力机制,显著提升了系统的翻译质量。实验结果表明,该系统在多语言场景下具有较强的扩展性,尤其在低资源语言的任务中表现尤为出色。未来的工作将继续探索如何将大语言模型(LLM)与现有系统结合,以进一步提升系统的翻译性能。

参考文献:

]Vaswani, A., Shazeer, N., Parmar, N., Attention is all you need,Advances in Neural Information Processing Systems, 2017.30, 5998-6008.

作者简介:姜菲红(1991.06),女,汉族,浙江杭州人,技术主管,大专,主要从事企业数字化及大数据智慧物流安全研究

京公网安备 11011302003690号

京公网安备 11011302003690号