- 收藏

- 加入书签

基于毫米波雷达与摄像头融合策略的方案研究

摘要:首先,介绍环境感知技术在高级别自动驾驶系统中的重要性,提出高级别自动驾驶环境感知方案通常包含摄像头、毫米波雷达、激光雷达等融合;简要阐述摄像头和毫米波雷达工作原理及优缺点。然后,介绍基于基于毫米波雷达和摄像头融合方案的策略,信号级融合、数据级融合、目标级融合的原理以及优缺点。最后,介绍基于某款量产车上应用毫米波雷达和摄像头的自动驾驶融合方案,详细介绍其在自动驾驶中的实践应用与优劣以及未来的发展方向。

关键词:高级别自动驾驶、毫米波雷达、摄像头、数据融合

1.引言

在复杂多变的交通环境下,自动驾驶技术的发展对于保障人们的乘车安全十分重要。环境感知是自动驾驶汽车研究领域中的关键技术[1]。实现自动驾驶方案主要使用的传感器有毫米波雷达,摄像头,激光雷达等,其中,毫米波雷达以其几乎全天时全天候的探测优势和较低的成本最先应用于自动驾驶领域,优点是工作稳定,不易受恶劣天气影响,探测距离最远可达200m,测距与测速精度较高,且成本较低,但在实际应用中对目标识别能力较差;激光雷达使用旋转激光阵列生成自动驾驶汽车周围环境的精确3D地图,但这种类型的传感器相当昂贵,可能需要大量的计算能力来解决光线和天气(雨、雾、雪)的不利影响;摄像头可以采集丰富的图像信息,极大拓展了环境感知系统的数据集。摄像头一般采用单目或者立体相机,前者探测距离更远。摄像头获取的数据量十分充足,可以精确前方目标,且成本较低。

然而,单一传感器由于其工作原理、稳定性等等因素,在面对复杂的道路环境和天气变化时各自存在一定的问题无论是毫米波雷达还是摄像头,都有难以回避的缺点。毫米波雷达易受杂波干扰,探测目标时会出现误检测和漏检测现象;摄像头则易受光线、雨、雾等影响,不能时刻保证接收到髙质量的图像数据。但相比于雷达传感器,光学摄像头数据量级较大,处理时间较长,并且在恶劣天气下稳定性较差。考虑到成本与优势互补,相比于激光雷达,毫米波雷达与摄像头价格较低,且毫米波雷达在恶劣天气的稳定性以及对于测速与测距的准确性可以与摄像头互补[2]。

因此有必要对这两种环境传感器进行融合,增强智能汽车在复杂环境背景下的目标探测能力。

2.毫米波与摄像头工作原理与优缺点

2.1 毫米波雷达

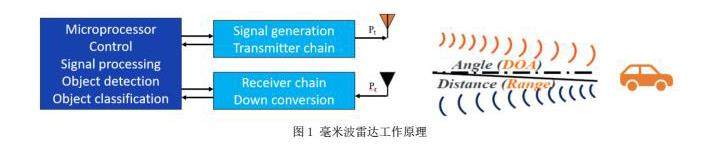

本节研究了基于线性调频连续波(Linear Frequency Modulated Continuous Wave,LFMCW)毫米波雷达的信号处理方法。从雷达原理入手,推导了目标信息获取的理论公式,研究了基于距离维,速度维,角度维的信号处理流程,实现了对目标位置信息和微多普勒信息的获取,从原理上解释毫米波雷达工作的优缺点。

毫米波是指波长为 1~10mm 的电磁波,对应的频率范围为30~300GHz。常用车规级雷达频率为24GHz和77GHz,对应的波长为12.5mm、3.9mm。毫米波雷达工作原理图,如图2所示,对目标发射电磁波,接收反射回波信号,测量回波的时间、相位等信号,解算目标的距离、速度、角度信息。

车载毫米波雷达单频连续波、移频键控、多进制数字频率调制、调频连续波和脉冲压缩序。因为调频连续波在探测距离和分辨率上存在优势,且信号处理简单,因此广泛应用,本文采取ARS408雷达。

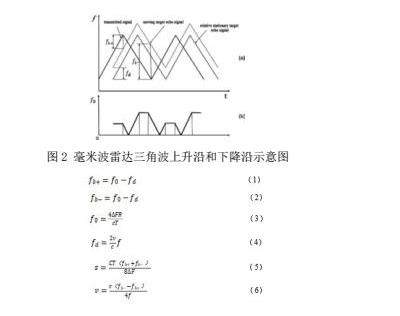

测距和测速

对目标对象处于相对运动状态时的情况进行分析,当接收到的信号从移动目标反射时,回波信号包括由于目标运动引起的多普勒频移fd,三角波上升沿fb+和下降沿fb-之间的中频信号f0如图所示。f是发射信号的中心频率, s是目标对象的相对距离,v是目标的相对运动速度,△F是带宽。

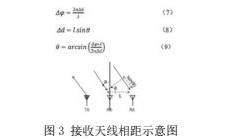

测角度

要对目标的角度进行测量,需要至少2个RX天线。目标到每个RX天线的距离不同将导致距离快速傅里叶变化峰值的相位变化,利用相位差即可测量到达角。图中△d为两接收天线之间的距离,即为到达角。由三角函数关系即可得到

从以上分析可以看出,毫米波雷达在不同的距离下存在测量误差,容易检测到环境中杂乱背景下的静态目标,通常剔除静态目标检测,因此但对目标识别能力较差。

2.2 摄像头

传统的视觉目标检测算法受天气与环境光照影响较大,并且需要进行图像预处理与手工设置图像特征,计算成本大,难以满足实时性要求。而基于深度学习的视觉目标检测算法相较于传统视觉目标检测算法,计算成本大大减少,准确性也大幅度提高。目前主流的基于深度学习的目标检测算法主要分为以 R-CNN 系列为主的 two-stage 算法与以 SSD、YOLO 系列为主的 one-stage 算法。two-stage 目标检测算法首先提取目标可能在图片中的候选区域,然后对候选区域进行特征提取与图像分类,整体技术框架是先定位,后分类。该类算法检测精度较高,但是检测速度较慢,无法满足实时性的需求。one-stage 目标检测算法不同于 two-stage 算法,没有 two-stage 算法中的 RPN(RegionProposal Network)结构,通过卷积神经网络提取特征,直接由原始数据得到目标的预测位置与类别,因此也被称为端到端(end to end)算法。该类算法虽然较 two-stage 算法精度稍差,但检测速度更快,更适合用于对实时性要求高的任务中。采用单目摄像头的自动驾驶感知系统可以准确地检测到目标,但由于缺少场景深度信息,难以确定目标的位置和尺度。

3.毫米波雷达和摄像头融合方案研究

综上,单一传感器由于其工作原理、稳定性等等因素,在面对复杂的道路环境和天气变化时各自存在一定的问题无论是毫米波雷达还是摄像头,都有难以回避的缺点,因此需要进行数据融合,提高自动驾驶安全性和稳定性。信息融合按数据抽象层次一般分为3类,信号级,数据级和目标级。信号级又称为像素级融合,融合层级最低,信息量损失最小,精度最高;数据量最大,实时性较差,不同传感器之间融合难度较大;数据级又称为特征级融合,数据量相对较小,实时性好,由于信息丢失,性能下降。目标级又称为决策级融合,通信量最小,融合处理代价低;融合层级最高,信息量损失最大,精度最差。

对自动驾驶来说,数据级融合是一种工程上最佳的实现方式。既没有丢失过多信息量,同时又保证了处理效率。数据级融合的输入数据具有以下特点多源和异构。多源异构信息融合(MSHIF)综合利用了不同传感器获得的信息,避免了单个传感器的感知局限性和不确定性,形成了对环境或目标的更全面的感知和识别,提高了系统的外部感知能力。

3.1基于可分辨单元的融合策略

数据级融合,是指将不同传感器的可分辨单元的数据直接融合,然后对融合后的数据进行进一步处理的融合过程[4]。基于可分辨单元通常用于多源图像融合以增强图像,另一种方法是将光学图像作为真实样本,并通过生成对抗网络生成雷达图像。自动驾驶过程中的多源异构像素级融合通常利用雷达或生成的图像的可分辨单元,然后从融合数据中提取环境特征和目标参数,用于进一步决策。FSBDU直接合并数据,无需深度信息提取。虽然可以最大程度地融合多源数据,但数据之间存在冗余,导致融合效率低。

3.2基于互补特征的融合策略

基于互补特征的融合策略结合从相应传感器数据中提取的多目标特征,然后应用融合的多传感器特征进行分类和识别[5]。因为异质传感器可以捕获同一目标的非相关尺寸特征,这为目标检测和识别提供了卓越的识别能力。自动驾驶系统中提取的特征包括目标参数提取和数据特征提取:

1)目标参数提取:包括从预处理数据中提取的目标的大小、距离、方向、速度和加速度等目标信息。许多研究提取雷达或激光雷达目标的位置特征,并通过生成感兴趣区域(ROI)来辅助图像识别,ROI将雷达检测目标的位置直接转换为图像以形成区域。

2) 数据特征提取:数据特征是从图像或其他处理数据中提取特征,如目标轮廓、纹理、时频特征和颜色分布,用于分类和识别。在计算机视觉中,通常在图像中生成大量可能包含目标的感兴趣区域(ROI),这些ROI通过预训练的分类模型进行分类。此外,具有最高置信度的ROI是目标所在的位置。以这种方式确定目标的位置需要大量计算。传统的机器学习方法通常需要提取标准特征,如Haar算子、HOG算子和灰度共生矩阵(GLCM),以从图像中提取特征,然后应用SVM、Adaboost和其他方法对这些特征进行分类。

基于互补特征的融合策略需要对原始数据进行一定程度的信息提取,并组合由多个传感器检测到的不相关维度特征或参数。高维特征在目标识别中具有更高的可分辨能力,从而提高了融合的效率,并突破了单个传感器的固有缺陷。近年来,由于直接应用现有的视觉模式识别神经网络体系结构,对组合多传感器特征的研究还不够深入。大多数研究都是基于目标参数提取的方法来实现互补特征融合策略。

3.3基于目标属性的融合策略

基于目标属性的融合策略是一种分布式数据处理过程,其中每个传感器提取目标参数并识别不同的目标以形成目标列表[6]。将融合多个目标列表,以获取可靠和真实的目标信息,避免误报和漏检。该相机提供高水平的二维信息,如颜色、强度、密度和边缘信息,而激光雷达提供三维点云数据。通过获得尽可能多的属性,它促进了人机交互和意图认知。行人检测采用了图像处理飞行传感器和摄像机传感器。此外,本研究还采用三维点云数据进一步检测目标的形状,以降低虚警率并解决基于摄像机的检测中的目标遮挡问题。在本文中,激光雷达的目标信息为图像生成ROI。这种融合策略使用多个传感器停止接收目标,并融合提取的目标属性或环境特征。该融合策略将提高感知系统的稳定性和可靠性,以应对单个传感器在独立检测和识别过程中可能出现误报或漏检。

4.基于毫米波雷达和摄像头融合的自动驾驶方案实践应用

某量产新能源车使用3颗毫米波雷达、12颗超声波雷达,以及遍布车身前视、侧视、环视等多角度的10颗高感知摄像头,共同编织成一张感知网,为车辆提供了全方位、立体化的环境感知能力。硬件层面,高清摄像头的广泛布局确保了车辆在不同光线、天气条件下的稳定识别能力,无论是城市街道的复杂交通环境,还是高速公路上的高速巡航,都能游刃有余。同时,毫米波雷达与超声波雷达的加入,则为系统提供了更远的探测距离和更精准的障碍物识别,进一步提升了智能驾驶的安全性和可靠性。软件层面,某量产新能源车利用乾崑智能的强力赋能。拥有了与特斯拉FSD相媲美的思维逻辑,更在决策和规划上实现了类人化的飞跃。系统能够基于实时感知数据,快速做出符合人类驾驶习惯的决策,规划出更加自然、流畅的行驶轨迹,从而大大提升了通行效率和驾驶舒适性。此外,通过不断的学习和优化,某量产新能源车智能驾驶系统还能够在复杂多变的道路环境中持续进化,为用户提供更加智能、安全的出行体验。在实际应用中,某量产新能源车主视觉方案展现出了惊人的实力。无论是城市拥堵路况下的自动跟车、变道超车,还是高速公路上的自动驾驶巡航,系统都能表现得游刃有余。特别是在面对一些突发情况时,如前方车辆急停、行人横穿等某量产新能源车能够迅速做出反应,采取避让措施,确保行车安全。

5.结语

某量产车型通过雷达和摄像头进行特征级数据融合,利用深度学习网联提取目标的多模态特征。通过分别采集两个异构传感器的数据,并完成异构传感器数据的对齐,并使用对齐后的数据训练检测模型。针对特征级融合中存在的雷达测量误差和投影融合误差问题,未来可通过扩展卡尔曼滤波算法对雷达数据进行预处理,同时采用自适应地学习策略,提高传感器的检测精度,降低传感器检测误差对融合检测的影响。同时雷达和相机传感器数据可采用时空关联方法,并完成多传感器数据的时空关联。

参考文献:

[1]张乐乐, 王丽, 肖小玲. 我国智能交通系统的发展现状和趋势[J]. 电脑知识与技术, 2021, 17(03): 247-249.

[2]孙轶凡. 基于毫米波雷达与摄像头协同的道路目标检测与识别技术研究[D]. 电子科技大学, 2022.

[3]Redmon J, Divvala S, Girshick R, et al. You Only Look Once: Unified, Real-Time Object Detection [C]. Proceedings of the IEEE conference on computer vision and pattern recognition. 2016: 779-788.

[4]王成. 基于毫米波雷达和视觉传感器信息融合的危险目标检测方法研究[D]. 吉林大 学, 2020.

[5]Sensor Fusion for Joint 3D Object Detection and Semantic Segmentation: https://arxiv.org/abs/1904.11466.

[6]Shi X,Ye Q,Chen X,et al.Geometry-based distance decomposition for monocular 3d object detection[c]//Proceedings of the IEEE/CVF International Conference on Computer Vision.2021: 15172-15181.

作者简介:郝剑峰+19910810+男+中国重庆+本科+助理工程师+基于毫米波雷达、摄像头的智能网联汽车高级驾驶辅助系统、单片机及智慧农业补光。

京公网安备 11011302003690号

京公网安备 11011302003690号